Ocho principios de política para guiar nuestra relación con la tecnología digital

Tecnología Digital

|

| Fuente: Shutterstock |

Las políticas han permitido el uso seguro de coches y aviones. No existen políticas similares para las redes sociales ni la IA. Se está avanzando para subsanar esta deficiencia, empezando por proteger a nuestros hijos.

Una función principal del gobierno es asegurar que el éxito económico entre las empresas esté ligado a la creación de valor real para otros. Pero hoy, muchos de los productos más rentables en nuestros teléfonos ya no se enfocan en proporcionar valor; en cambio, apuntan a consumir nuestro tiempo. En un juicio reciente , Mark Zuckerberg testificó que solo el 20% del contenido consumido en Facebook y el 10% del contenido consumido en Instagram proviene de amigos. La misión original de "conectar a las personas" ha sido reemplazada. "La gran mayoría de la experiencia", admitió, "es más sobre explorar tus intereses, entretenimiento ..." Pero bajo esta vaga noción de "intereses" y "entretenimiento", casi cualquier cosa puede justificarse, incluidos los productos que mantienen la atención de muchos niños " casi constantemente ". Nada puede justificar que los niños vean a extraños pelear entre sí, vean bailes sexualmente sugerentes o formen relaciones románticas con chatbots de IA. Lo que importa no es si el contenido se percibe como valioso o significativo. En cambio, lo que importa es solo que mantenga a las personas, especialmente a los niños, interesadas y comprometidas. Y para muchas empresas, dar a la gente más de lo que “quiere” resulta estar perfectamente alineado con sus resultados.

Pero estar "entretenidos" por nuestros teléfonos no es necesariamente lo que la gente realmente quiere, al menos no en el sentido considerado y aspiracional. Pregúntale a las personas que te rodean, niños o adultos, y encontrarás que muchas personas quieren pasar menos tiempo en su teléfono. En una encuesta reciente , el 53% de los estadounidenses reportaron querer reducir el uso del teléfono, y el 79% nombró a las redes sociales como la aplicación de teléfono más adictiva. Aproximadamente el 70% de la Generación Z reportó sentir que su salud mental y vida social mejorarían con menos tiempo en el teléfono. En la propia investigación de Meta , encontraron que en la última semana, el 70% de los usuarios reportaron haber visto contenido que querían ver menos, a menudo varias veces y solo dentro de los primeros 5 minutos de abrir la aplicación. Los adolescentes se hacen eco del mismo sentimiento. En un estudio reciente de Pew , el 45% de los adolescentes reportan que pasan demasiado tiempo en las redes sociales y que las redes sociales perjudican la cantidad de sueño que obtienen. El 44% reporta intentar reducir el uso de su teléfono y redes sociales.

Para muchas empresas, dar a la gente más de lo que “quiere” resulta estar perfectamente alineado con sus resultados.

Muchos aspiramos a usar menos el teléfono, pero las aplicaciones están diseñadas para que lo usemos más. Estas aplicaciones van en contra de nuestro buen juicio, distrayéndonos cuando preferiríamos estar pasando tiempo con nuestros seres queridos, concentrándonos en el trabajo o durmiendo bien. Para los adultos, esto es triste. Para los niños, es negligente y moralmente incorrecto.

Los científicos sociales suelen hablar de dos tipos de toma de decisiones: rápida y lenta . El pensamiento rápido es inmediato, instintivo y está impulsado por impulsos evolucionados, como la búsqueda de azúcar, sexo, conflicto y estimulación. Pero nuestro pensamiento más lento y deliberado apunta a objetivos diferentes. La mayoría de nosotros no aspiramos a consumir más azúcar, ver más pornografía, presenciar más peleas ni apostar más. Aspiramos a comer más sano, tener relaciones significativas, llevarnos bien con nuestros amigos y vecinos, y tener un futuro financiero estable. El problema es que muchos productos digitales explotan nuestros instintos de pensamiento rápido y, al mismo tiempo, socavan activamente nuestras aspiraciones de pensamiento lento.

La discrepancia entre lo que las personas esperan de la tecnología y lo que realmente obtienen es ampliamente reconocida por científicos sociales y especialistas en ética tecnológica, así como por padres, docentes y los propios adolescentes. En todo el mundo, se está generando un impulso para abordar los perjuicios de las plataformas basadas en la interacción y que maximizan el tiempo.

En el resto de esta publicación, analizo cuatro objetivos principales para la protección infantil en línea y ocho principios específicos para elaborar soluciones políticas eficaces y viables. Dada la diversidad de productos tecnológicos, no existe un enfoque único para todos. Por eso, el equipo de Anxious Generation ha estado trabajando en diversas jurisdicciones y herramientas políticas para impulsar reformas que protejan a los niños y reajusten la tecnología a nuestras aspiraciones.

Objetivo 1: Verificación efectiva de la edad y límites de edad

No permitimos que los jóvenes de 14 años soliciten tarjetas de crédito porque reconocemos que aún están desarrollando su capacidad para tomar decisiones a largo plazo. Sin embargo, les permitimos firmar contratos de forma independiente con grandes corporaciones, cediendo los derechos sobre sus hábitos, pensamientos e imágenes, sin asegurarnos de que comprendan las implicaciones. Esta falta de protección es alarmante: niños de diez años mienten habitualmente para acceder a plataformas, y muchos adolescentes más jóvenes reciben a menudo contenido sexual inesperado y no deseado . Las empresas tienen pocos incentivos financieros para abordar estos riesgos, por lo que se necesitan soluciones políticas.

Si bien la necesidad de una verificación de edad eficaz es evidente, es fundamental integrar cuidadosamente en cualquier política las preocupaciones importantes sobre la privacidad y la libertad de expresión. Cualquier esfuerzo requerirá una mayor recopilación de datos y podría limitar el acceso a la información. Los responsables políticos, los tecnólogos y los abogados han trabajado para equilibrar estas consideraciones, a menudo con la ayuda de los tribunales, y las posibles soluciones se han vuelto más claras. A continuación, se presentan cuatro principios que pueden guiar a los responsables políticos en este complejo terreno.

Principio n.° 1: Limite la creación de cuentas, NO el acceso al contenido.

Las jurisdicciones deberían sentirse libres de limitar la capacidad de los menores de entablar relaciones legales con las plataformas, especialmente cuando estas utilizan cada vez más esos datos para entrenar modelos de IA .

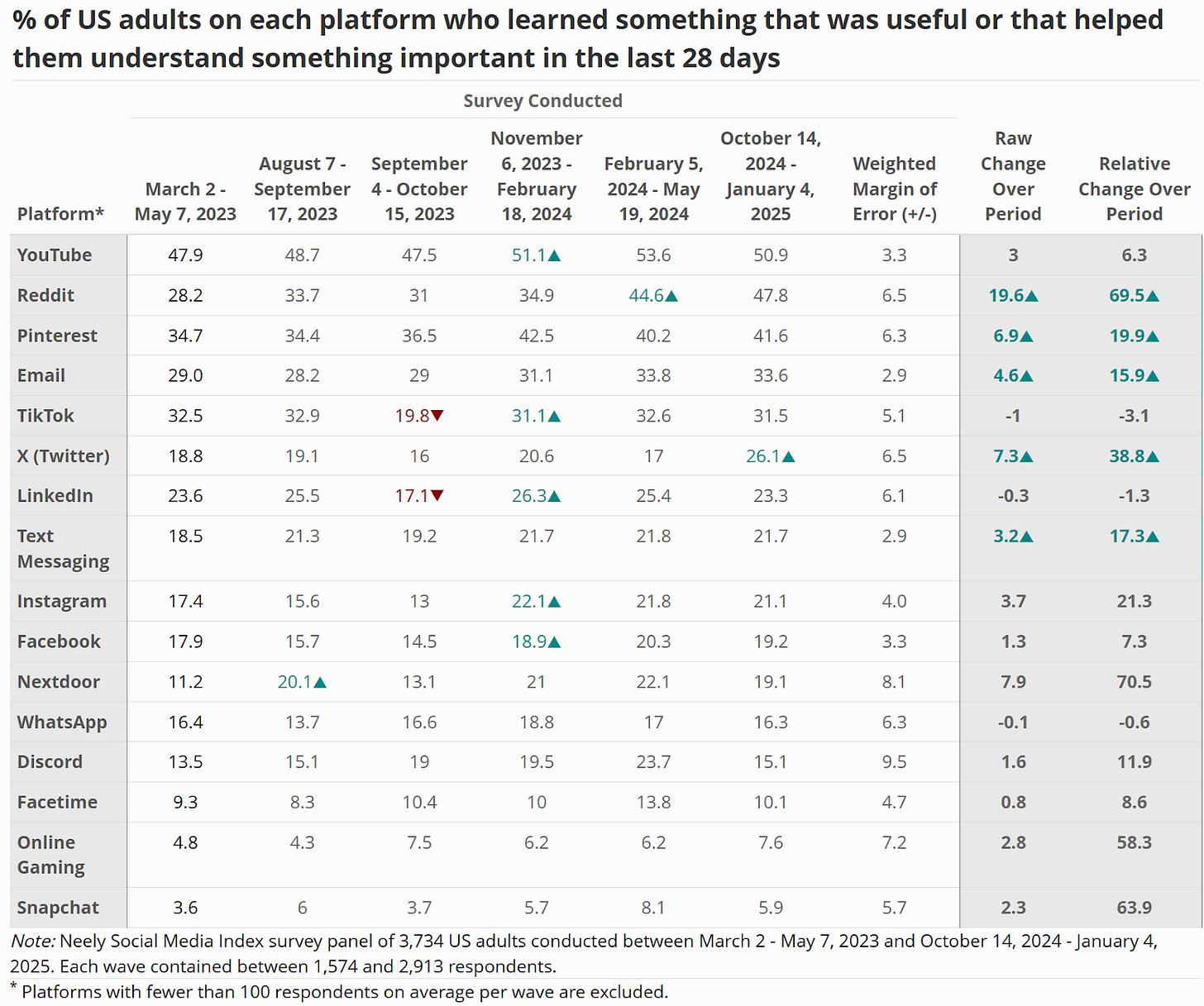

Las plataformas más informativas no requieren que los usuarios creen cuentas. En el Centro Neely de la USC Marshall , encuestamos periódicamente a una muestra representativa de adultos estadounidenses, preguntándoles si han aprendido algo útil o que les haya ayudado a comprender algo importante. En nuestros datos más recientes, Reddit (47,8 %) y YouTube (50,9 %) encabezaron la lista. Ambos servicios permiten el acceso sin cuenta, y el auge de Reddit en nuestros datos se corresponde con un número cada vez mayor de usuarios que acceden al contenido a través de búsquedas de Google sin iniciar sesión . Esto demuestra que las plataformas pueden aportar valor sin exigir datos personales ni la creación de cuentas.

La legislación australiana sobre el límite de edad en redes sociales se centra en impedir que los menores de 16 años creen cuentas. Muchos países europeos están siguiendo el ejemplo , y varios estados de EE. UU. también han considerado o aprobado leyes que limitan la creación de cuentas. Esta distinción es importante: no se restringe el acceso al contenido, sino las relaciones legales que las plataformas crean con los menores para recopilar datos y aumentar la retención . Sería muy fácil para Instagram permitir que cualquier adolescente acceda al contenido de Taylor Swift , pero es casi imposible hacerlo sin recibir ventanas emergentes agresivas que te piden que te registres en una cuenta que quizás no quieras. Acceder a Twitter/X también es cada vez más difícil sin una cuenta.

Si las plataformas realmente se preocupan por el acceso de los jóvenes al contenido, deberían seguir el ejemplo de YouTube y Reddit y aceptar el acceso sin conexión a sus servicios. De no ser así, las jurisdicciones deberían tener la libertad de limitar la capacidad de los menores para establecer relaciones legales con las plataformas, especialmente cuando estas utilizan cada vez más esos datos para entrenar modelos de IA .

Principio n.° 2: Limitar el acceso a funciones de diseño perjudiciales, no solo a las redes sociales

Las plataformas deberían enfrentarse a una elección clara: eliminar las funciones riesgosas o restringir el acceso a los menores.

En Australia y otros lugares, debates surgen sobre qué plataformas deberían regirse por las nuevas leyes de límite de edad. Sin embargo, en lugar de definir qué servicios se consideran "redes sociales", los reguladores deberían centrarse en qué características generan riesgo.

Indonesia promulgó recientemente una normativa integral para proteger a los niños en línea, clasificando las plataformas como de bajo o alto riesgo según la probabilidad de contacto con desconocidos, exposición a contenido dañino y comportamientos adictivos. Las aplicaciones de mensajería pueden suponer riesgos de contacto con desconocidos, dependiendo de cuánto fomenten dichas conexiones o gamifiquen dicha interacción (por ejemplo, las funciones Quick Add y Streaks de Snapchat ). Riesgos similares también existen en diversos productos que permiten la mensajería, incluso en productos dirigidos a niños, como Roblox .

Los motores de recomendación impulsados por IA que fomentan el uso excesivo de un producto o recomiendan contenido atractivo pero potencialmente dañino o no deseado están presentes en muchas aplicaciones, no solo en aquellas tradicionalmente asociadas con las "redes sociales".

A través de colaboraciones con el Instituto Knight-Georgetown y el Proyecto de Justicia Legal Tecnológica , el Centro Neely trabaja para identificar todas las características de diseño que aumentan el riesgo de experiencias perjudiciales para los usuarios, de modo que las protecciones puedan centrarse en las características que han demostrado ser perjudiciales. En lugar de intentar definir qué plataformas se consideran redes sociales, trabajamos para ayudar a los reguladores a identificar las características específicas que aumentan el riesgo en los servicios en línea. Las plataformas deben enfrentarse a una decisión clara: eliminar las características riesgosas o restringir el acceso a menores.

Principio n.° 3: Minimizar la verificación de edad: habilitar protecciones a nivel de dispositivo

En lugar de preocuparse si alguna aplicación individual conoce la edad de su hijo y restringe adecuadamente el contacto con extraños, pueden esperar protecciones sólidas en todas las aplicaciones y sitios web.

Existen preocupaciones razonables sobre cómo identificar a los menores sin comprometer la privacidad ni la libertad de expresión de los adultos. Si bien no queremos que los menores accedan a contenido sexual o sobre suicidio, tampoco queremos que se disuada a los adultos de acceder a dicho contenido si lo buscan. Un adulto podría no querer proporcionar identificación para acceder a contenido sensible por temor a que su consumo pueda ser rastreado o expuesto. Cualquier aumento en la verificación conlleva cierto riesgo para la privacidad.

Para minimizar estos riesgos, tanto The Anxious Generation como el Neely Center Design Code recomiendan permitir que los propietarios de dispositivos configuren protecciones a nivel de dispositivo. Estas configuraciones exigirían que las aplicaciones respeten las preferencias del propietario del dispositivo (incluidos los padres), como reducir el contacto no deseado, el contenido no deseado o limitar los patrones de diseño que prolongan el uso. Muchos niños mayores con discapacidades, así como adultos mayores, también agradecerían estas configuraciones. En EE. UU., donde los padres informan que las redes sociales y la tecnología representan las mayores amenazas para la salud mental de sus hijos, estas protecciones probablemente presentarían una ventaja competitiva para los fabricantes de dispositivos que desean brindarles tranquilidad. En lugar de preocuparse por si alguna aplicación individual conoce la edad de su hijo y restringe adecuadamente el contacto con desconocidos, pueden esperar protecciones sólidas en aplicaciones y sitios web.

Más allá de estas configuraciones, las sociedades seguirán queriendo establecer restricciones razonables que no sean voluntarias, al igual que existen restricciones involuntarias basadas en la edad en relación con el alcohol, el tabaco, los juegos de azar, la conducción y el voto. En esos casos, la mejor práctica es verificar la edad a nivel de dispositivo, lo que permite que una única señal se propague entre aplicaciones y sitios web. Los fabricantes de dispositivos ya están elaborando planes para facilitar este proceso, lo que significa que las nuevas regulaciones podrán basarse en los procesos establecidos.

Ya se están iniciando los primeros esfuerzos: Utah aprobó la Ley de Responsabilidad de las Tiendas de Aplicaciones (App Store Accountability Act ), que exige que las tiendas de aplicaciones verifiquen las edades. Buffy Wicks de La Ley de Garantía de la Era Digital en California va un paso más allá y exige la verificación a nivel de dispositivo. Sin embargo, ambas leyes podrían mejorarse (1) permitiendo protecciones voluntarias independientemente de la edad, (2) exigiendo explícitamente que las aplicaciones mantengan una mayor responsabilidad, y (3) garantizando que las aplicaciones dañinas se diferencien adecuadamente (véase la siguiente sección). A pesar de estas limitaciones, muestran que se está abandonando la verificación aplicación por aplicación, y este cambio debería reducir los riesgos para la privacidad y reforzar las limitaciones basadas en la edad.

Principio n.° 4: Garantizar una responsabilidad significativa y un consentimiento informado para aplicaciones de alto riesgo

También advertimos contra la excesiva dependencia de los mecanismos de consentimiento parental. Las tiendas de aplicaciones pueden facilitar el consentimiento, pero si se vuelve rutinario, pierde su significado.

A medida que las señales a nivel de dispositivo estén disponibles, las aplicaciones dañinas no tendrán más remedio que restringir sus servicios de forma más adecuada. Es inexcusable que búsquedas sencillas como "feliz décimo cumpleaños" sigan mostrando cuentas activas de menores de edad en muchas plataformas importantes. Estas empresas también deberían estar obligadas a utilizar los datos que ya recopilan, a menudo con fines de marketing, para mejorar las iniciativas de verificación de edad.

Recomendamos el lenguaje del Código de diseño en línea apropiado para la edad de Nebraska :

El conocimiento real incluye toda la información e inferencias conocidas por el servicio en línea cubierto relacionadas con la edad del individuo, incluida, entre otras, la edad autoidentificada y cualquier edad que el servicio en línea cubierto haya atribuido o asociado con el individuo para cualquier propósito, incluido el marketing, la publicidad o el desarrollo de productos.

También advertimos contra la excesiva dependencia de los mecanismos de consentimiento parental. Si bien las tiendas de aplicaciones pueden facilitar el consentimiento, cuando el proceso se vuelve demasiado rutinario, pierde sentido. Es posible que los padres no comprendan del todo las implicaciones de aprobar el uso de las redes sociales. Dado este riesgo, recomendamos encarecidamente la eliminación de cualquier requisito para facilitar el consentimiento parental, especialmente cualquiera que pueda utilizarse para integrar abiertamente a usuarios menores de 13 años mediante procesos que cumplan con la COPPA .

Tanto la Ley de Responsabilidad de la App Store como la Ley de Garantía de la Era Digital conllevan este riesgo crítico y no podemos apoyar ninguna de ellas mientras incluyan estas disposiciones. Es necesario diferenciar las aplicaciones dañinas de las muchas aplicaciones inocuas que los padres aprobarán, o de lo contrario corremos el riesgo de sufrir una " fatiga del consentimiento ".

Objetivo 2: Escuelas libres de distracciones y teléfonos celulares

Una forma sencilla pero eficaz de proteger a los niños en línea es brindarles un verdadero descanso del mundo digital durante la jornada escolar. El impulso bipartidista a favor de escuelas sin teléfonos está creciendo en estados tan diversos como Vermont, Arkansas, Ohio y California, y en países tan diversos como Dinamarca , Brasil y China .

La razón de esta política es clara: en un estudio reciente en EE. UU. , los niños pasaban un promedio de 90 minutos de una jornada escolar de 6,5 horas en sus teléfonos. Independientemente de su actitud hacia la tecnología, esto representa un desperdicio extraordinario de atención y recursos educativos.

Principio n.° 5: Implementar restricciones de uso de teléfonos escolares durante todo el día, de timbre a timbre

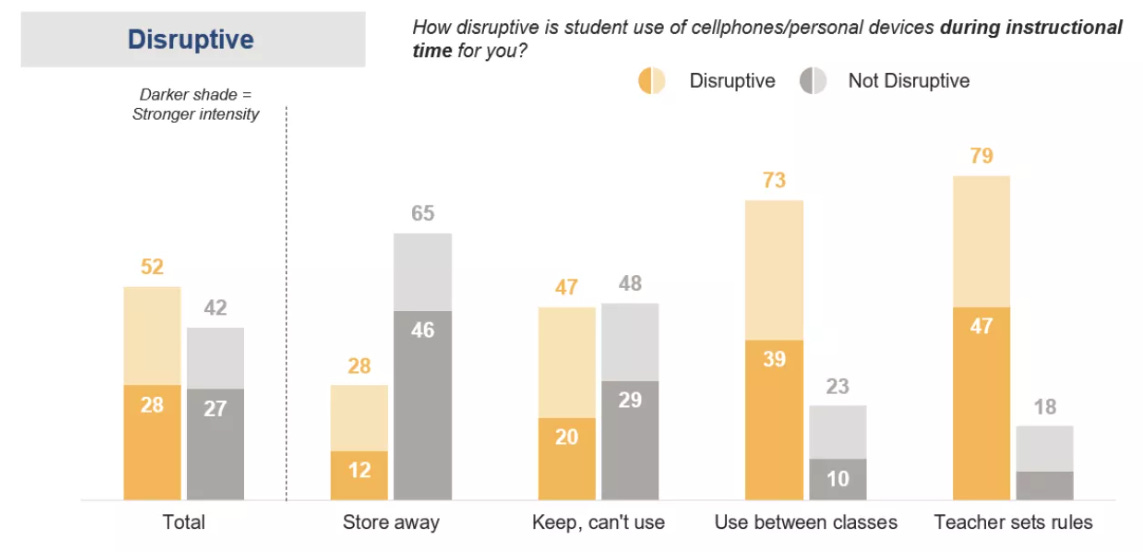

Las encuestas muestran que más del 90% del profesorado apoya las restricciones al uso de teléfonos por parte de los estudiantes en la escuela, y la mayoría de los distritos escolares ya están implementando alguna versión de esta política. Sin embargo, estas políticas varían considerablemente en alcance y eficacia.

En Texas, por ejemplo, la representante Caroline Fairly lideró la aprobación de una verdadera restricción telefónica "de timbre a timbre", incluso cuando el cercano Nuevo México solo restringía los teléfonos celulares durante las horas de clase . El equipo de Anxious Generation se ha asociado con el Centro Marshall Neely de la USC , Fairplay , la Fundación Becca Schmill , el Movimiento de Escuelas Libres de Teléfonos y ExcelinEd para educar a los legisladores sobre la importancia de estos detalles y por qué las restricciones de jornada completa son mucho más efectivas que las parciales.

En lugares como Colorado y Minnesota, donde las políticas pueden variar considerablemente entre distritos, trabajamos para que datos como el gráfico a continuación, de la Asociación Nacional de Educación (NEA), sean de dominio público. El hallazgo clave: a menos que los teléfonos se guarden durante todo el día, los docentes dedican tiempo valioso de clase a pedirles repetidamente a los estudiantes que los guarden.

De una encuesta realizada a docentes por la Asociación Nacional de Educación :

Detrás de cada punto de datos “de timbre a timbre” en este gráfico se encuentra la historia de un docente que logró pasar de ser el “policía del teléfono” a ser un educador.

A continuación se muestran dos ejemplos entre muchos:

Greg Cabana, un veterano profesor de gobierno, recuerda una época en la que su trabajo como educador parecía secundario, a diferencia de ser el guardián del teléfono. "Era absolutamente cada clase", declaró Cabana a CNN. "No se trataba de si los estudiantes sacarían sus celulares, sino de cuánto tiempo lo harían". Este año, sin embargo, ya no libra esa batalla...

“Recuerdo el primer día que estuve en física, con el teléfono guardado en la mochila y lo buscaba constantemente, pero no podía, y lo único que podía hacer era sentarme frente a la computadora y escuchar”, dijo Alex Heaton, estudiante de penúltimo año. “Fue muy liberador”.

Prevemos que todas las escuelas estarán completamente libres de teléfonos en unos pocos años. Ya sea que estas políticas se implementen a nivel nacional, regional, distrital o individual, se ha iniciado un movimiento, y los informes de profesores y administradores son muy positivos. Incluso a los estudiantes parecen gustarles las políticas después de unas semanas, ya que se dan cuenta de que es más divertido hablar, bromear y jugar con sus amigos que pasar el tiempo libre navegando.

Esperamos que más naciones, estados, distritos y escuelas individuales adopten políticas de “campana a campana”.

Objetivo 3: Espacios en línea más seguros que respalden la autonomía del usuario

Comprender el diseño riesgoso de las plataformas no solo es útil para identificar cuáles deberían implementar límites de edad. También es esencial para proteger a los usuarios, incluidos muchos jóvenes, que seguirán usándolas.

Principio n.° 6: Establecer estándares mínimos de diseño para espacios en línea

Ninguna plataforma debería ser recompensada por crear productos más baratos, menos seguros y más manipulables a expensas de la salud y el bienestar a largo plazo de sus usuarios.

Ahora sabemos mucho más sobre cómo las decisiones de diseño específicas generan daños específicos. Estos daños generalmente se clasifican en cuatro categorías:

Contacto no deseado o dañino (por ejemplo, incitación o acoso sexual)

Contenido no deseado o dañino (por ejemplo, contenido violento, sexual o perturbador)

Uso no deseado o excesivo (por ejemplo, a través de algoritmos, desplazamiento infinito, rachas o reproducción automática)

Uso indebido de datos, imágenes e identidad de una persona

Dentro de esta taxonomía , hemos comenzado a examinar los mecanismos de diseño específicos asociados a cada categoría de daño. Un informe actualizado, publicado por el Fiscal General de Minnesota, Keith Ellison, vincula los daños con características específicas de diseño, y se están realizando más investigaciones para ampliar esta base de evidencia. Seguimos apoyando los esfuerzos para investigar y reformar las decisiones de diseño perjudiciales, incluyendo cómo podríamos reformar los algoritmos y cómo podríamos medir los efectos de las reformas .

Esta creciente comprensión del diseño de plataformas ya está empezando a influir tanto en las políticas como en el comportamiento en ellas. Meta ha tomado medidas para aumentar la privacidad de los jóvenes . Pinterest ha promovido públicamente la práctica del diseño algorítmico prosocial. Reddit se ha consolidado como una fuente de información accesible para todos , no solo para quienes tienen una cuenta de Reddit. El hecho de que algunas plataformas adopten diferentes decisiones de diseño significa que es posible que todas tengan funciones de privacidad, diseño y algoritmos que realmente beneficien a las personas. Ninguna plataforma puede afirmar lo contrario con credibilidad.

Estas prácticas de diseño se están traduciendo en estándares mínimos de diseño. Estados tan diversos ideológica y geográficamente como Nebraska , Carolina del Sur y Vermont están considerando seriamente esta legislación, gracias al liderazgo de la representante Monique Priestley , el representante Brandon Guffey y el gobernador Jim Pillen, entre muchos otros. Actualmente, estamos trabajando con socios globales en políticas y regulación para difundir estos estándares mínimos en todas las jurisdicciones.

Ninguna plataforma debería ser recompensada por crear productos más baratos, menos seguros y más manipulables a expensas de la salud y el bienestar a largo plazo de sus usuarios.

Principio n.° 7: Facilitar la competencia mediante la interoperabilidad y una política fiscal justa

Los estándares de diseño ayudan a elevar el límite inferior. Pero los responsables políticos también pueden elevar el límite superior creando incentivos de mercado que conduzcan a un uso más eficaz de la tecnología.

En Utah, la recientemente promulgada Ley de Elección Digital (liderada por el representante de Utah, Doug Fiefia ) exige que las plataformas faciliten la interoperabilidad y la portabilidad de datos. Esto significa que los usuarios pueden transferir con mayor facilidad sus redes, datos y plataformas digitales que se ajusten mejor a sus valores. El equipo de Anxious Generation testificó a favor de esta legislación porque creemos que las familias no deberían verse limitadas a plataformas que no satisfacen sus aspiraciones. Si una plataforma en particular ya no satisface sus necesidades, debería tener la libertad de migrar sus datos y red a una plataforma de la competencia. Con el tiempo, esta libertad incentivaría a las plataformas a satisfacer las necesidades de los usuarios, en lugar de las ganancias comerciales.

Otros legisladores buscan mejorar los incentivos del mercado mediante impuestos. Minnesota, Maryland y Washington han considerado la posibilidad de imponer impuestos a las plataformas digitales con la idea de que las externalidades de estas plataformas deberían ser sufragadas por ellas mismas. Si el 45 % de los adolescentes reporta dormir menos debido a las redes sociales, un impuesto modesto para cubrir el costo de abordar las consecuencias de esa falta de sueño —que directamente generó mayores ingresos publicitarios para las plataformas— parece justo y proporcional al daño.

Objetivo 4: Protección contra los riesgos emergentes de la inteligencia artificial

Principio n.° 8: Abordar los daños emergentes de la IA: imágenes no consensuadas y chatbots explotadores

Nuestro objetivo no es sólo abordar los riesgos bien documentados de las redes sociales, sino también evolucionar nuestra comprensión para enfrentar los riesgos emergentes que la tecnología plantea al bienestar psicológico, especialmente para grupos vulnerables como los jóvenes.

Dos de los riesgos más urgentes que la IA supone para los jóvenes hoy en día son:

Apego a los chatbots de IA

Imágenes generadas por IA sin consentimiento (también conocidas como deepfakes)

En un estudio reciente de Common Sense Media , el 24 % de los adolescentes reportó usar chatbots de IA al menos varias veces por semana. Ya hemos visto surgir perjuicios de alto perfil, incluyendo demandas contra empresas como Character.ai por implementar chatbots que seducen a los jóvenes usuarios, convenciéndolos de que están conversando con seres sensibles que expresan amor, admiración e intimidad emocional.

Mientras tanto, un estudio del Centro para la Democracia y la Tecnología reveló que el 40 % de los jóvenes reportaron conocer deepfakes de IA que representan a individuos en su escuela. El 15 % incluía representaciones sexualmente explícitas y el 18 % representaciones ofensivas, pero no sexuales. Si bien ambos perjuicios afectan a una minoría de la población, esta minoría aún representa a millones de jóvenes.

No tenemos que repetir los errores que cometimos en las redes sociales, donde no supimos anticipar ni mitigar los riesgos.

Muchos en la industria tecnológica lo comprenden. Las empresas son plenamente conscientes de la demanda contra Character.ai y muchos empleados buscan directrices de diseño claras para evitar la manipulación de los usuarios jóvenes. En el Centro Neely, trabajamos para desarrollar principios de diseño que las empresas puedan seguir, y muchos legisladores, como el Asambleísta Bauer-Kahan de California , están desarrollando normativas para garantizar que se sigan las mejores prácticas.

La legislación sobre deepfakes también ha comenzado a tomar forma, pero hasta ahora se ha centrado estrictamente en imágenes sexualmente explícitas. Hay mucho más por abordar. Junto con el Proyecto de Justicia Legal Tecnológica , hemos trabajado con legisladores de Georgia (con la representante Sally Harrell ) y Minnesota (con la senadora Erin Maye-Quade ) en una legislación que extendería los derechos sobre la imagen de una persona a todos los rasgos identificables (por ejemplo, voz, rostro, gestos) y al uso no sexual y no consensuado. Esperamos que para 2026 se consolide la idea intuitiva de que todos tenemos derechos sobre nuestra propia imagen.

Creando el mundo que queremos

Las tecnologías digitales modernas pueden ser herramientas extraordinarias. Pero, como cualquier herramienta, pueden usarse para bien o para mal. Innovaciones como la tecnología nuclear y los drones han salvado vidas y se han utilizado para matar. Las redes sociales también conservan el potencial de conectar a las personas, educar y potenciar la creatividad humana. Sin embargo, actualmente, la mayoría de las plataformas están optimizadas no para el valor a largo plazo, sino para la interacción a corto plazo. En un mercado que prioriza la atención por encima de todo, no podemos esperar mejores resultados sin cambiar los incentivos.

Por eso, reformas como la verificación de edad a nivel de dispositivo, la interoperabilidad, los estándares mínimos de diseño, la tributación y otras protecciones para los jóvenes son esenciales. Sin ellas, las plataformas seguirán haciendo lo mismo: maximizar el tiempo dedicado a expensas de la salud mental, la privacidad y la conexión.

Éste no tiene por qué ser nuestro futuro.

Terminaré con una cita de Chris Cox , un veterano ejecutivo de Facebook y cercano a Mark Zuckerberg. Muchos se han inspirado en esta cita en Meta:

La historia de las redes sociales aún no está escrita, y sus efectos no son neutrales. Como sus creadores, debemos esforzarnos por comprender su impacto —tanto lo bueno como lo malo— y asumir la labor diaria de orientarla hacia lo positivo y hacia lo bueno. Esta es nuestra mayor responsabilidad.

La pregunta ahora es: ¿cuántos de los "creadores" de plataformas actuales aún creen en esta cita de 2019? Si analizamos algunas declaraciones internas de las empresas , vemos que hay quienes luchan por esta visión. Pero con demasiada frecuencia, pierden las batallas ante incentivos a corto plazo, la presión de las partes interesadas o la inercia institucional. Por eso, padres, educadores y legisladores deben sumarse a la lucha.

Creamos la infancia basada en el teléfono. Podemos revertirla y construir algo mejor

Sobre el autor:

| El artículo se puede leer en inglés en After Babel/Substack |

Comentarios